前言

记录使用 ollama 部署 deepseek 的过程。

安装 ollama

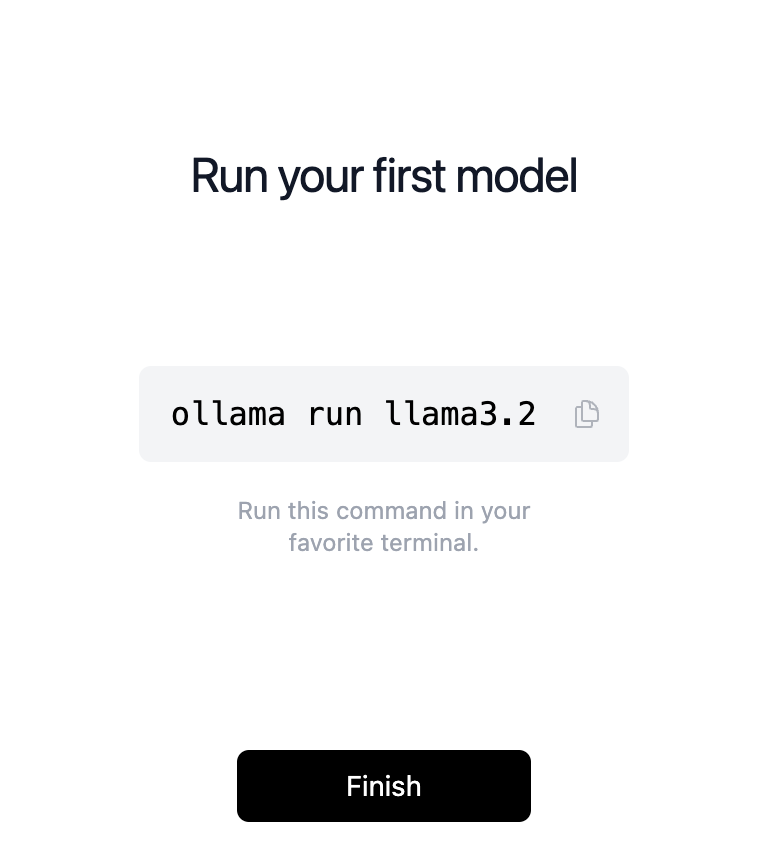

ollama download,下载好以后双击安装。安装 OK 以后,就会看到如下界面:

1 | 在你本地的终端命令行工具里,输入如下命令,就会开始安装一个 llama3.2b 模型了 |

Llama 3.2 是由 Meta 开发的开源大型语言模型系列,包括轻量级文本模型(1B 和 3B)和视觉模型(11B 和 90B)。这些模型适用于多种应用场景,如文本摘要、指令跟踪、图像理解及视觉推理,特别适合需要在边缘设备上高效运行并保护用户隐私的任务 1。它们支持多语言处理,并能在智能手机等设备上实现智能化升级,提供个性化的用户体验和服务。

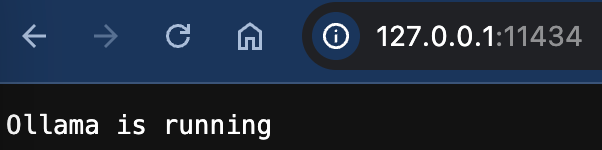

ollama 本地端口是 11434,通过通过访问 http://127.0.0.1:11434/ 来查看运行状态:

建议运行前,先运行:export OLLAMA_HOST=0.0.0.0:11434,这样方便局域网内可以通过本机 IP:11434 方式进行访问。

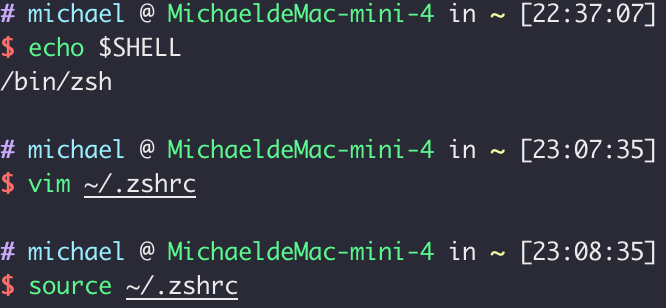

为了避免每次运行之前都设置这个环境变量,可以提前在终端工具的本地文件中加入上面这个命令:

部署 deepseek-r1 本地模型

在 ollama/models 这里可以看到一系列支持的模型,并且,提供了部署命令:

deepseek 官方的监控:https://status.deepseek.com/

ollama 常用命令

1 | 列举本地模型文件 |

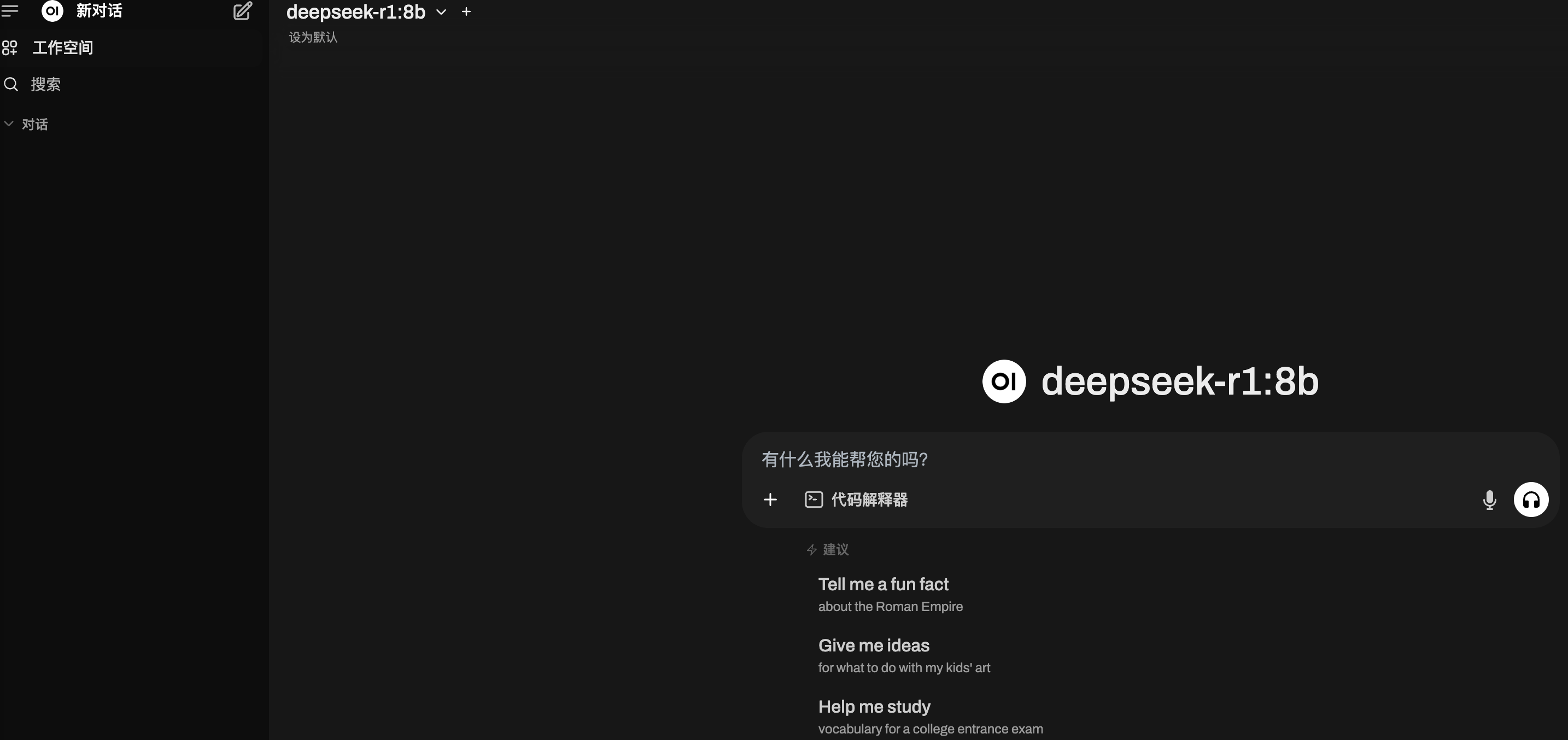

Page Assist - 本地 AI 模型的 Web UI

chrome 插键 Page Assist - 本地 AI 模型的 Web UI 提供了一个 UI 界面方便和 ollama 的模型进行交互,比在终端界面方便多了。

安装 Open WebUI

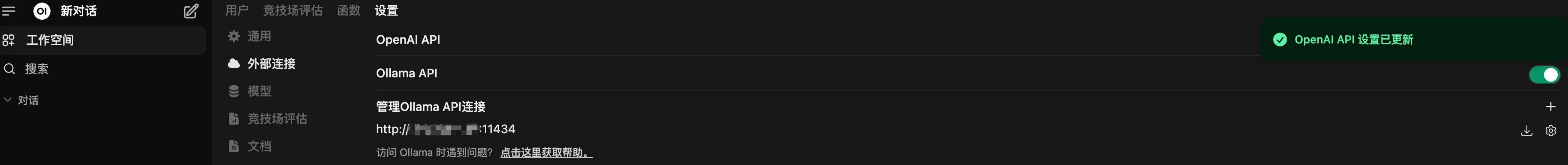

为了能够通过浏览器更好的界面来使用模型,可以通过 NAS 安装 Open WebUI 来对接 ollama 的模型。

安装镜像:dyrnq/open-webui

官方有 Wiki 说明:open-webui

两个重要的变量:

OLLAMA_BASE_URL=http://<IP>:11434—— Ollama 服务器的地址WEBUI_SECRET_KEY=<password>可以理解成密码,自定义即可

设置本地 ollama 模型的地址:

参考

- 本地部署DeepSeek R1模型, 有手就行,含全功能的webUI界面

- 适配Ollama的前端界面Open WebUI

- 本地部署大模型openwebui(ollama部署的deepseetR1)联网搜索的一种解决方案